Techniczne SEO to działania, które bardziej przypominają programowanie strony oraz administrowanie serwerem, niż typową optymalizację witryny. Techniczna optymalizacja strony w niewielkim stopniu będzie widoczna dla użytkownika. Bardzo duże znaczenie ma jednak, jak strona zostanie odebrana przez wyszukiwarkę. Techniczne SEO skupia się na strukturze serwisu i jej elementach, które są brane pod uwagę w rankingu stron. Mowa tutaj o prawidłowym indeksowaniu strony, renderowaniu, szybkości ładowania, dostosowaniu do urządzeń mobilnych, a także o dostępności witryny dla robotów wyszukiwarki. Takie działania w przypadku małej strony typu onpage, będą zauważalne w poprawie widoczności, czy szybszej indeksacji. Jednak w przypadku sklepu internetowego, takie działania będą miały ogromny wpływ na widoczność, pozycję w wynikach wyszukiwania i szybkości ładowania.

Umożliwienie wyszukiwarce łatwiejszej interpretacji zasobów witryny to nie wszystko. Techniczne SEO niesie za sobą wiele korzyści dla użytkownika. Optymalizacja techniczna sklepu umożliwia wygodniejsze przeglądanie zasobów, krótki czas ładowania treści, ale także dostosowanie ich do konkretnego urządzenia. Techniczna optymalizacja opiera się na kilku ważnych elementach.

Spis treści:

- Certyfikat SSL

- Przekierowania

- Robots.txt

- Mapa strony

- Przyjazne adresy URL

- Dostosowanie do urządzeń mobilnych

- Streszczenie

- Podsumowanie

Certyfikat SSL

Pierwszym krokiem technicznej optymalizacji SEO powinno być bezpieczeństwo. Instalacja certyfikatu SSL i protokołu HTTPS, zapewnia bezpieczeństwo przesyłanych danych, przez szyfrowanie całego połączenia. Dlatego przesyłane dane do realizacji zamówienia oraz dane dotyczące płatności, są zabezpieczone.

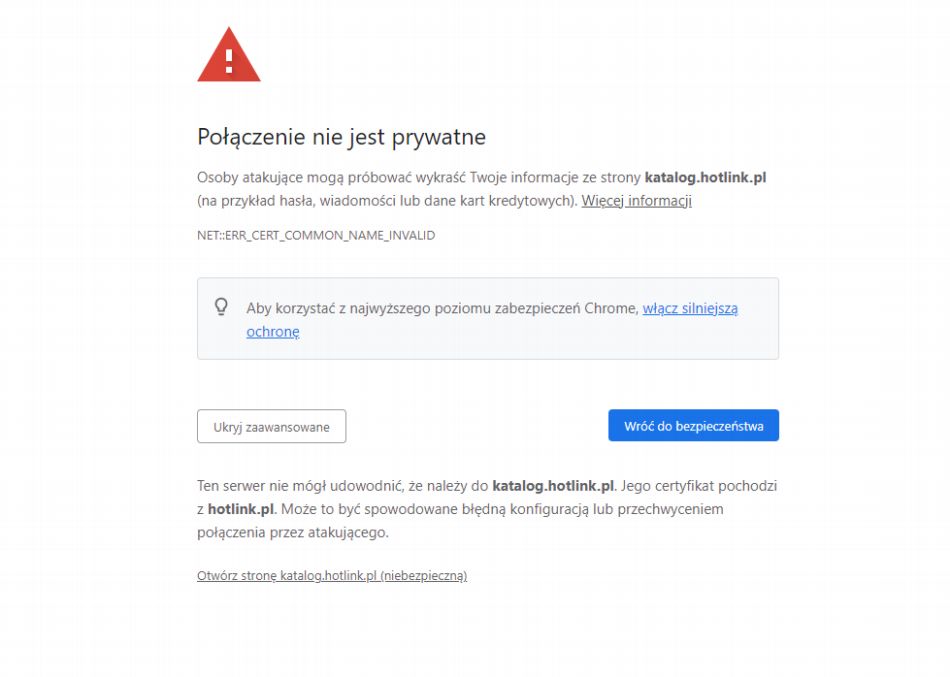

Wdrożenie certyfikatu SSL ma bardzo duże znaczenie dla pozycjonowania strony. Sklep internetowy bez wdrożonego SSL nie zdobędzie zaufania użytkowników. Odwiedzając niezabezpieczoną stronę przeglądarka nas informuje o niebezpieczeństwie. Przed adresem strony zostanie wyświetlony komunikat „Niezabezpieczona”.

![]()

Jest to pierwszym sygnałem dla użytkownika, który może spowodować opuszczenie strony. W przypadku stron z różnymi skryptami, które nie posiadają wdrożonego certyfikatu bezpieczeństwa, zostaje wyświetlony komunikat o niebezpieczeństwie. Dopiero po zaakceptowaniu niebezpieczeństwa, użytkownikowi zostaje wyświetlona strona.

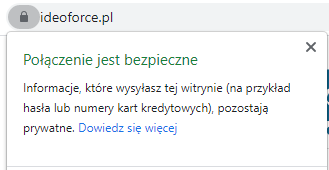

Prawidłowo wdrożony certyfikat SSL oraz protokół HTTPS w wyszukiwarce jest sygnalizowany symbolem zamkniętej kłódki. Po kliknięciu w ten symbol zostaje wyświetlona informacja o bezpieczeństwie witryny.

Obecnie wdrożenie certyfikatu SSL, a także protokołu HTTPS stało się już standardem. W zależności od wielkości witryny i zapotrzebowania, mamy do dyspozycji kilka rodzajów certyfikatu SSL.

Przekierowania

Przekierowania przekazują informacje wyszukiwarce, że należy przejść na inny adres URL. Utworzenie przekierowań może wynikać z usuniętych zasobów lub z błędnych adresów URL. Przekierowania również można wykorzystać podczas tymczasowych prac nad stroną. To pozwala na wyświetlanie odpowiednich treści, typu „Strona w budowie”.

Dlatego odpowiednia optymalizacja przekierowań jest ważna. Ustawienie odpowiednich przekierowań, zapobiega wyświetlaniu błędów o niedziałającej stronie. Jest to bardzo ważne również z punktu widzenia użytkownika, któremu zostają wyświetlone treści zamiast błędu. Wykorzystuje się je również w momencie przenoszenia zasobów pod inny adres URL.

Jak informuje Google roboty potrafią sobie poradzić z dwoma przekierowaniami, jednak większa ilość działa na niekorzyść. Po wdrożeniu certyfikatu SSL będzie wykonanie przekierowania z adresu http na adres https. W innym przypadku otrzymamy dwa różne adresy URL o tej samej treści. Również musimy określić jak adres sklepu internetowego ma wyglądać. Bardzo ważne jest zadbanie o optymalizację przekierowań, pod względem wyszukiwarki oraz użytkownika.

Kolejnym przekierowaniem jakie jest obowiązkowe to wykonanie przekierowania na adres z przedrostkiem „www” lub bez niego. Dla zwykłego użytkownika nie będzie miało to znaczenia, jednak dla wyszukiwarki to będą dwa różne adresy URL. Tym samym będziemy mieć duplikat treści całego sklepu.

Jeśli optymalizację przekierowań wykonujemy już w funkcjonującym sklepie, bardzo pomocne są narzędzia do wykonywania audytów. Wykrywają one adresy URL w zasobach witryny, które posiadają przekierowania. Dzięki temu do sprawdzenia pozostaje mniejsza liczba adresów.

Robots.txt

Plik robots.txt to plik zawierający instrukcje przeznaczone dla robotów wyszukiwarki. Znajduje się on na serwerze w folderze głównym i wskazuje jakie adresy w naszej witrynie powinny zostać pominięte podczas indeksacji.

Robots.txt umożliwia nam ograniczenie indeksowania podstron w sklepie internetowym. Nasuwa się tutaj pytanie po co blokować indeksowanie stron? Strony takie jak rejestracja, czy koszyk zawierają treści często dostępne dopiero po zalogowaniu. Dlatego mogą negatywnie wpływać na pozycjonowanie z powodu duplikacji treści. Podczas optymalizacji należy sprawdzić czy zostały wykluczone z indeksacji prawidłowe strony. W pliku robots.txt również podaje się adres URL, gdzie znajduje się sitemap witryny. Umożliwia to szybszą indeksację zasobów witryny.

Warto zauważyć, że instrukcje jakie znajdują się w pliku, są jedynie zaleceniami dla robotów. Robot może podążyć za naszymi zaleceniami, ale nie musi. Nie tylko Googlebot indeksują nasza witrynę, ale również roboty innych wyszukiwarek. Największe wyszukiwarki zapewniają, że stosują się do zaleceń znajdujących się w robots.txt.

Mapa strony

Mapa strony, czyli plik sitemapl.xml znajdujący się na serwerze, który posiada mapę adresów URL całej witryny. Adresy jakie umieszczone są w mapie strony nie powinny zwracać błędów 404 lub posiadać przekierowań.

Plik umożliwia szybsze indeksowanie i wykrywanie nowych stron robotom indeksującym wyszukiwarki. Odgrywa ona szczególną rolę w sklepach internetowych, gdzie mamy do czynienia z dużą liczbą podstron. Mapa usprawnia pracę indeksacji i robot sam nie musi przeszukiwać całej witryny w poszukiwaniu nowych podstron.

Takie rozwiązanie ma zapobiegać spamowaniu. Dlatego w przypadku przekroczenia tego limitu, należ stworzyć kilka mniejszych sitemap, gdzie w głównym pliku tworzymy indeks mniejszych map strony.

Jednak by nasza mapa strony miała sens istnienia musi zostać zgłoszona w Google Search Console. Dzięki temu roboty wyszukiwarki będą znały jej lokalizację i szybko przejdą do jej indeksacji. Dodatkowo adres URL mapy strony warto umieścić w pliku robots.txt.

Przyjazne adresy URL

Jakiś czas temu Google potwierdziło informacje, że przyjazne adresy URL, są elementem rankingowym. Musi być on czytelny, czyli nie może zawierać podkreśleń oraz ciągu niezrozumiałych znaków. Liczby, znaki i słowa powinny być oddzielone odpowiednim separatorem, jakim jest myślnik „ – ” .

Zapisz się na newsletter i bądź na bieżąco z naszymi artykułami. Nie przegap najciekawszych tekstów.

Administratorem udostępnionych przez Ciebie danych osobowych jest Ideo Force Sp. z o.o. Podanie danych osobowych jest dobrowolne, jednak ich niepodanie uniemożliwi świadczenie usług na Twoją rzecz. Dowiedz się więcej o zasadach przetwarzania Twoich danych osobowych oraz przysługujących Ci uprawnieniach w Polityce prywatności.

Odpowiednia konstrukcja adresu umożliwia umieszczenie w nim słowa kluczowego, na które nasza strona będzie pojawiała się w wynikach wyszukiwania. Dodatkowo adres URL powinien zawierać ścieżkę jaką przechodzi użytkownik od strony głównej do produktu.

Przykładowo:

https://adres-sklepu.pl/nazwa-kategorii/nazwa-produktu

Należy jednak pamiętać, aby adres URL nie był zbyt długi, ponieważ nie będzie wtedy przyjazny. W przypadku dużego zagnieżdżenia kategorii warto w adresie URL umieścić najważniejszą kategorię i podkategorię, wraz z nazwą produktu. Wiele platform sprzedażowych, czy oprogramowania e-commerce, umożliwia automatyczne generowanie przyjaznych adresów URL. Mogą one być generowane według schematu, który zostanie wybrany.

Dostosowanie do urządzeń mobilnych

Urządzenia mobilne dzięki swojej dużej popularności wypierają urządzenia desktopowe. Do przeglądania stron i robienia zakupów najczęściej wykorzystywane są właśnie urządzenia mobilne. Dlatego bardzo ważne jest, aby sklep internetowy oraz jego treści odpowiednio były wyświetlane na małych ekranach.

Na czas ładowania sklepu mają duży wpływ obrazki, ale również wielkość skryptów, wykorzystanych do stworzenia sklepu. Dlatego instalowanie dużej ilości dodatkowych wtyczek, które tak naprawdę są niepotrzebne, jest niezalecane. Wiele animacji, ciekawych ruchomych elementów tła, na dużym ekranie wyglądają wspaniale. Jednak na ekranie telefonu, nie będą wyglądać tak ciekawie lub będą utrudniać interakcję.

Brak błędów

Sklep internetowy składa się z dużej liczby podstron, a to prowadzi do występowania błędów na stronie. Najczęściej występujący problem w dużych witrynach to błąd 404 (Strona nie istnieje). Jest to zmora każdego sklepu internetowego. Kolejnym bardzo często występujący to błąd 500 (Błąd Serwera). Zarządzanie dużą ilością produktów, dodawanie nowych produktów ich aktualizacja, prowadzi często do wystąpienia błędów.

Google Search Console umożliwia na wykrycie wszystkich błędów jakie pojawiają się na stronie, oczywiście pod względem wyszukiwarki. Dodatkowo dzięki temu narzędziu możemy wykryć wiele innych problemów, jakie występują w witrynie.

Mimo wszystko warto wykorzystać dodatkowe narzędzia, jak np.: crowler. Umożliwi on przeskanowanie wszystkich zasobów witryny w poszukiwaniu błędów, typu: duplikat title, duplikat treści, zerwanych obrazów, błędów w sitemap i robots, a także rodzajów wykorzystanych przekierowań.

Schema - dane strukturalne

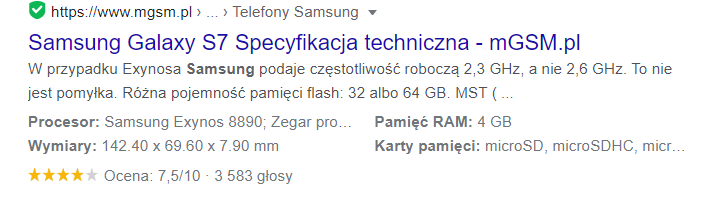

Wdrożenie danych strukturalnych polega na dodaniu do struktury strony specjalnych znaczników. Pozwalają one na opisanie zawartości strony w sposób zrozumiały dla wyszukiwarki. Ich prawidłowe wdrożenie umożliwiają wyświetlanie dodatkowych elementów witryny w wynikach wyszukiwania.

Jak możemy zauważyć wdrożenie danych strukturalnych, daje użytkownikowi ważne informacje już w wynikach wyszukiwania. Warto również zauważyć, że wyszukiwarka Google docenia wdrożenie schema w rankingu stron. Co najważniejsze, przedstawiony na obrazku przykładowy wynik wyszukiwania, wyróżnia się na tle innych. To może spowodować, że użytkownik chętniej kliknie w link do naszego sklepu.

Canonical URL

Każdy z nas spotkał się, czy to na blogu, czy w sklepie internetowym z paginacją, która umożliwia wygodne wyświetlenie większej ilości produktów lub artykułów. Niesie ona za sobą jednak kłopotliwy aspekt, a mianowicie duplikację treści.

Każda podstrona będzie posiadała ten sam opis kategorii, a jedynym zmiennym elementem będzie lista produktów. W takim przypadku roboty wyszukiwarki uznają to za duplikat content. Ma to bardzo negatywny wpływ na pozycjonowanie. Dlatego rozwiązaniem tego problemu jest w sekcji header ustalić główny adres canonical.

Dla wyszukiwarki idealnym rozwiązanie jest, gdy dla jednej podstrony odpowiada jeden adres URL. Bardzo często w sklepie internetowym takie rozwiązanie nie jest możliwe. Dlatego to rozwiązanie pozwala na ograniczenie duplikacji treści.

Adres URL pierwszej strony ustalamy jak nasz główny adres i taki oznaczamy na kolejnych podstronach w paginacji. Informujemy wtedy wyszukiwarkę, że ten pierwsza podstrona jest najważniejsza, a pozostałe to jej dalsza część.

Core Web Vitals

Core Web Vitals to wskaźniki dotyczące: czasu wczytywania, interaktywności oraz stabilności ładowania treści strony internetowej. Tak więc CWV, responsywność, bezpieczeństwo, szyfrowanie połączenia oraz brak nachalnych reklam, stały się podstawowymi elementami sklepu internetowego.

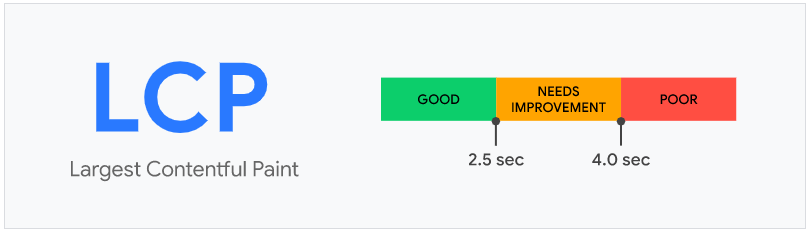

Largest Content Paint (LCP) to wskaźnik szybkości ładowania strony. To czas jaki jest potrzebny do załadowania największego elementu na stronie.

Rysunek 1 https://web.dev/lcp/.

Wielkość do 2,5s jest uznawana za dobry wynik, jednak czas powyżej 4s jest słabym wynikiem. Głównymi elementami mającymi wpływa na czas ładowania strony to:

- Obrazki

- Wideo

- Czas odpowiedzi serwera

- Blokowanie renderowania CSS i JavaScript

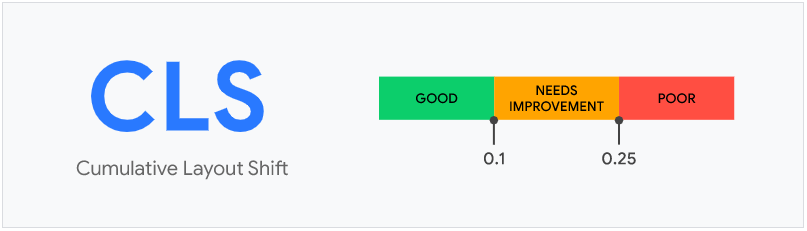

Cumulative Layout Shift (CLS) to kolejny wskaźnik, który dotyczy nieoczekiwanej zmiany układu strony. Bardzo często jest to zauważalne podczas ładowania strony, kiedy najpierw zostaje załadowany blok z tekstem, a później jest on przesunięty w dół, ponieważ zostaje załadowany obrazek nad tym blokiem.

Mowa oczywiście tutaj o przesunięciach, które nie są inicjowane przez użytkownika. Wiele przesunięć, czy zmian układu może być inicjowane przez użytkownika. Przykładem może tutaj być rozwijane menu, rozwijane bloki oraz wiele więcej.

Rysunek 2 https://web.dev/cls/.

Podczas technicznej optymalizacji sklepu warto skupić się, aby wskaźnik CLS był jak najniższy. W wielu przypadkach wymaga to usunięcie jakiegoś elementu lub jego przebudowę. Może to być rozbudowany slider, który ze względów swojej struktury powoduje niestabilność pozostałych elementów.

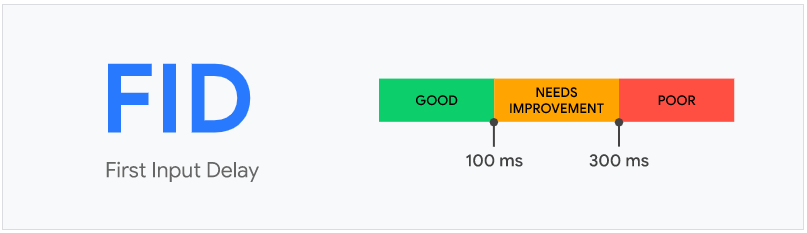

First Input Delay (FID) kolejny wskaźnik, który mierzy czas od pierwszej interakcji użytkownika, do momentu, aż przeglądarka rozpocznie przetwarzanie zdarzenia. Optymalny wynik tego wskaźnika to czas poniżej 100 ms.

Rysunek 3 https://web.dev/fid/.

Core Web Vitals to również kilka innych wskaźników, które możemy mierzyć dzięki narzędziu PageSpeed Insight. Umożliwia to wykonanie optymalizacji kłopotliwych elementów, dzięki zaleceniom jakie zostają wygenerowane po zakończonym teście. Jak można zauważyć osiągnięcie optymalnych wyników Web Vitals bardziej opiera się na programowaniu niż na standardowej optymalizacji. Duży wpływ na wskaźniki CWV ma szablon strony oraz wykorzystane dodatkowe moduły. Ograniczenie niepotrzebnego kodu lub zasobów zewnętrznych pozwala na osiągnięcie dobrych wyników.

Breadcrumps

Sklep internetowy składa się z reguły z dużej liczby podstron (kategorie, produkty, blog), przez co cała struktura strony jest duża. Im większa struktura tym trudniej przeglądać jej zasoby. Dlatego też odpowiednia nawigacja umożliwia użytkownikom łatwiej poruszać się w strukturze naszego sklepu.

Nawigacja okruszkowa jest dodatkowym elementem nawigacyjnym, który pozwala skategoryzować zawartość względem zapytania wyszukiwarki. Breadcrumps są umieszczone w górnej części strony, pozwalając na szybsze poruszanie się po stronie.

Duplikacja treści

Wyszukiwarka Google od dłuższego czasu docenia wartościowe oraz unikalne treści, dlatego należy zadbać o brak występowania duplikacji treści na stronie. Najczęściej do duplikacji dochodzi podczas dodawania produktów do sklepu. Przez pomyłkę lub niedopatrzenie ten sam produkt jest dodawany dwa razy do dwóch różnych kategorii. Ten sam opis, zdjęcia jednak dwa różne adresy URL. To jest przykład duplikacji wewnętrznej. Bardzo często również do duplikacji dochodzi podczas tworzenia wersji językowych.

Do duplikacji zewnętrznej dochodzi w przypadku kopiowania opisów produktów czy kategorii. Dlatego tak duży nacisk należy kłaść na unikalność treści w sklepie internetowy.

Hreflang

Hreflang to nic innego jak atrybut informujący roboty wyszukiwarki o języku strony. Dzięki temu mamy możliwość przygotowania kilku wersji językowych oraz walutowych naszego sklepu.

Atrybut hreflang informuje wyszukiwarkę, że jest to ta sama treść, skierowana do różnych użytkowników. Co jest bardzo ważne strony powiązane tym atrybutem, nie są traktowane jako duplikat. Pozwala to na kierowanie użytkowników do odpowiednich treści, pod względem ich regiony oraz języka. Efektem tego będzie zmniejszenie czynnika odrzuceń.

Protokół http

Podstawowy protokół przesyłania dokumentów hipertekstowych to właśnie HTTP. Komunikacja opiera się na wysłaniu zapytania przez klienta i odpowiedzi serwera. Sam protokół nie przechowuje danych, dlatego wykorzystywany jest mechanizm ciasteczek.

Jednym z punktów technicznej optymalizacji jest sprawdzenie wersji protokołu i jeśli to możliwe uruchomienie najnowszej wersji.

- HTTP /1.1 – pierwsza wersja protokołu, opierająca się na tekstowych komunikatach i wielokrotnie przesyłanych nagłówków. Bardzo często spotykany jeszcze w użyciu.

- HTTP /2 – następca, który wprowadza w komunikacji format binarny oraz kompresję nagłówków. Komunikacja odbywa się jednym połączeniem TCP, podczas którego są ranki. Obecnie standardowa wersja protokołu jaka jest wykorzystywana. Ta wersja umożliwia na szybsze przesyłanie danych, a tym samym szybsze ładowanie strony.

- HTTP /3 – najnowsza wersja protokołu w przeciwieństwie do poprzednich wersji nie wykorzystuje TCP. Wykorzystuje protokół transportowy UDP, co usprawnia transmisję danych. Dzięki temu strona może jeszcze szybciej się ładować.

Wykorzystanie najnowszej wersji protokołu może przyczynić się do poprawy czasu ładowania strony, szczególnie w przypadku urządzeń mobilnych. Do sprawdzenia wersji protokołu HTTP możemy wykorzystać wiele darmowych narzędzi. Jednym z najpopularniejszym narzędziem do sprawdzania jest GeekFlare.

Serwer

Bardzo ważną rolę w szybkim czasie ładowania strony odgrywa serwer. W przypadku sklepów internetowych wszystkie możliwości skrócenia czasu oczekiwania należy wykorzystać.

W zależności od potrzeb i wielkości sklepu należy wybrać odpowiedni hosting. Warto tutaj rozważyć dedykowane rozwiązania pod konkretne oprogramowanie sklepu. Pozwala to na prawidłowe funkcjonowanie platformy sprzedażowej. Przy wyborze hostingu warto zapoznać się jakiego typu dyski są wykorzystywane, limity, przydziały CPU i RAM i dostępność najnowszych technologii.

Bardzo dobrym rozwiązaniem jest również wykorzystanie CloudFlare, który pozwala na zabezpieczenie IP serwera, ale również na skrócenie czasu odpowiedzi. W zależności od lokalizacji użytkownika łączy się z najbliższym punktem CloudFlare. Dzięki temu otrzymuje on najszybszą trasę DNS do serwera. Warto tutaj jednak skupić swoją uwagę na odpowiedniej konfiguracji. Zablokowanie robotów indeksujących lub duże ograniczenie ich wejść, może mieć negatywne skutki. Mianowicie mowa tutaj o braku indeksacji wszystkich podstron i innych zasobów naszego sklepu internetowego.

Indeksowanie

Wszystkie wprowadzone zmiany i optymalizacje nie będą miały sensu jeśli sklep będzie nieindeksowany. Dlatego należy sprawdzić czy w kodzie strony nie został zaimplementowany tag:

<meta name="robots" content="noindex">

Powodem może być ustawienie w CMS sklepu, które uniemożliwia indeksowanie robotom. Jeśli jednak opcja jest wyłączona, a w kodzie sklepu nadal widnieje oznacza to ręcznie dodanie tagu w kodzie szablonu. W takim wypadku będzie konieczna edycja kodu i wstawienie domyślnej zawartości wykorzystywanego CMS.

Streszczenie

- Techniczne SEO skupia się na strukturze serwisu i jej elementach, które są brane pod uwagę w rankingu stron.

- Optymalizacja techniczna sklepu umożliwia wygodniejsze przeglądanie zasobów, krótki czas ładowania treści, ale także dostosowanie ich do konkretnego urządzenia.

- Instalacja certyfikatu SSL i protokołu HTTPS, zapewnia bezpieczeństwo przesyłanych danych, przez szyfrowanie całego połączenia.

- Sklep internetowy bez wdrożonego SSL nie zdobędzie zaufania użytkowników.

- Przekierowania przekazują informacje wyszukiwarce, że należy przejść na inny adres URL. Nie należy jednak tworzyć łańcuchów przekierowań, które zmuszają roboty indeksujące to przejścia kilka adresów nim trafią do celu.

- Plik robots.txt to plik zawierający instrukcje przeznaczone dla robotów wyszukiwarki. Znajduje się on na serwerze w folderze głównym i wskazuje jakie adresy w naszej witrynie powinny zostać pominięte podczas indeksacji.

- Mapa strony, czyli plik sitemapl.xml znajdujący się na serwerze, który posiada mapę adresów URL całej witryny. Adresy jakie umieszczone są w mapie strony nie powinny zwracać błędów 404 lub posiadać przekierowań. Mapa mapa może zawierać do 50 000 adresów URL, a jej maksymalny rozmiar to 50MB.

- Przyjazne adresy URL, są elementem rankingowy. Musi być on czytelny, czyli nie może zawierać podkreśleń oraz ciągu niezrozumiałych znaków. Liczby, znaki i słowa powinny być oddzielone odpowiednim separatorem, jakim jest myślnik „ – ” .

- Bardzo ważne jest, aby sklep internetowy oraz jego treści odpowiednio były wyświetlane na małych ekranach.

- Google Search Console umożliwia na wykrycie wszystkich błędów jakie pojawiają się na stornie, oczywiście pod względem wyszukiwarki.

- Wdrożenie danych strukturalnych polega na dodaniu do struktury strony specjalnych znaczników. Pozwalają one na opisanie zawartości strony w sposób zrozumiały dla wyszukiwarki.

- Paginacja umożliwia wygodne wyświetlenie większej ilości produktów lub artykułów. Adres URL pierwszej strony ustalamy jak nasz główny adres i taki oznaczamy na kolejnych podstronach w paginacji. Informujemy wtedy wyszukiwarkę, że ten pierwsza podstrona jest najważniejsza, a pozostałe to jej dalsza część.

- Core Web Vitals to wskaźniki dotyczące: czasu wczytywania, interaktywności oraz stabilności ładowania treści strony internetowej.

- Wdrożenie tzw. Breadcrumbs (nawigacja okruszkowa) umożliwia łatwe poruszanie się po witrynie użytkownikom oraz robotom wyszukiwarki.

- Wyszukiwarka Google od dłuższego czasu docenia wartościowe oraz unikalne treści, dlatego należy zadbać o brak występowania duplikacji treści na stronie.

- Hreflang to nic innego jak atrybut informujący roboty wyszukiwarki o języku strony. Dzięki temu mamy możliwość przygotowania kilku wersji językowych oraz walutowych naszego sklepu.

- Podstawowy protokół przesyłania dokumentów hipertekstowych to właśnie HTTP. Komunikacja opiera się na wysłaniu zapytania przez klienta i odpowiedzi serwera. Sam protokół nie przechowuje danych, dlatego wykorzystywany jest mechanizm ciasteczek.

- Bardzo ważną rolę w szybkim czasie ładowania strony odgrywa serwer.

- Sklep musi zostać zaindeksowany. W celu sprawdzenia poprawności indeksacji należy sprawdzić czy w kodzie strony nie został zaimplementowany tag: <meta name="robots" content="noindex">.

Podsumowanie

Jak możemy zauważyć technicznych aspektów, które odgrywają dużą role w SEO jest wiele. Omówione elementy, możemy potraktować jako taką podstawową listę. Do sprawdzenia pod względem technicznym jest o wiele więcej elementów. Chociażby wielkość plików CSS, JavaScript, ilości niewykorzystywanego kodu, wersje wykorzystywanych technologii oraz wiele więcej.

Dlatego optymalizacja techniczna SEO, powinna zostać wykonana z odpowiednim umiarem. Nie wolno zapominać, że głównym celem istnienia sklepu jest sprzedaż, a nie dobre wyniki testów SEO. Tak więc poprawa niektórych elementów umożliwi poprawę rankingu, wynikiem czego będzie zwiększenie sprzedaży lub widoczności. Jednak wysokie pozycje nie zapewnią sprzedaży, jeśli sklep nie będzie przyjazny użytkownikowi.